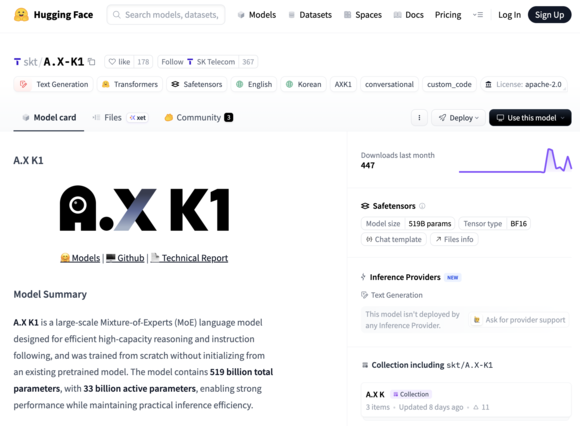

SK텔레콤 정예팀이 매개변수 5190억 개 규모의 초거대 인공지능 모델 ‘A.X K1’의 기술 보고서를 오픈소스 플랫폼 허깅페이스에 공개했다.

7일 SK텔레콤에 따르면, A.X K1은 약 4개월의 개발 기간 동안 1000개 수준의 GPU 자원을 활용해 완성됐다. 국내에서 5000억 개 이상 매개변수를 갖춘 초거대 모델이 공개된 것은 이번이 처음이다. SK텔레콤 정예팀은 제한된 자원 안에서 효율을 극대화하는 설계를 통해 대규모 모델 학습을 성공적으로 수행했다.

A.X K1은 주요 글로벌 오픈소스 모델과의 비교에서도 경쟁력을 보였다. 수학 성능을 평가하는 AIME25 벤치마크에서 89.8점을 기록하며 딥시크-V3.1의 88.4점 대비 102% 수준의 성능을 나타냈다. AIME25는 미국 고등학생 수학 올림피아드 문제를 기반으로 한 평가로, AI의 고난도 추론 능력을 측정한다.

코딩 성능을 평가하는 LiveCodeBench에서는 영어 기반 75.8점, 한국어 기반 73.1점을 기록했다. 이는 영어 69.5점, 한국어 66.2점을 기록한 딥시크-V3.1 대비 각각 109%, 110%에 해당하는 수치다. LiveCodeBench는 최신 실시간 코딩 문제로 구성돼 실제 개발 환경에서의 활용도를 가늠하는 지표로 활용된다.

SK텔레콤 정예팀은 학습 효율을 높이기 위해 스케일링 이론에 기반한 모델 설계를 적용했다. 학습 가능 자원과 기간을 고려해 최적의 모델 크기를 산출하고, 약 10조 개에 달하는 웹 데이터, 코드, 이공계 데이터, 추론 데이터 등을 활용해 학습을 진행했다. 한국어 특화 PDF 문서를 파싱해 활용하고, 난이도별 커리큘럼 학습 방식도 도입했다.

특히 이번 프로젝트는 정부 지원 없이 SK텔레콤 자체 GPU 조달만으로 추진됐다는 점에서 의미가 크다. 투입된 GPU 자원 대비 학습 효과를 극대화하기 위해 연산량을 수학적으로 설계하고, 학습 안정성을 체계적으로 관리했다는 설명이다.

A.X K1은 전문가 혼합 구조를 적용한 점도 특징이다. 전체 5190억 개 파라미터 가운데 330억 개만 선택적으로 활성화하는 방식으로, 훈련 안정성과 효율성을 동시에 확보했다. 이를 통해 대규모 모델임에도 학습 부담을 줄이고 성능을 유지했다.

이와 함께 A.X K1은 한 번에 최대 12만8000토큰의 긴 문맥을 처리할 수 있다. 한국어 기준 약 10만 단어 분량으로, 소설 한 권이나 기업 연간보고서 전체를 동시에 분석할 수 있는 수준이다.

SK텔레콤은 향후 A.X K1에 멀티모달 기능을 추가하고, 모델 규모를 조 단위 파라미터로 확장할 계획이다. 추가 컴퓨팅 자원과 데이터를 투입해 성능 고도화를 이어가며 글로벌 초거대 AI 경쟁에 본격적으로 나선다는 구상이다.

<문화경제 황수오 기자>

- 관련태그

- SK텔레콤 A.X K1 초거대 AI 딥시크-V3.1 허깅페이스